开源大模型王座再易主,1320亿参数DBRX上线,基础、微调模型都有。这是迄今为止最强大的开源大语言模型,超越了之前的领先模型。本周三,Databricks开源了DBRX,这款拥有1320亿参数的混合专家模型。DBRX的基础和微调版本已经发布,可用于研究和商业用途。

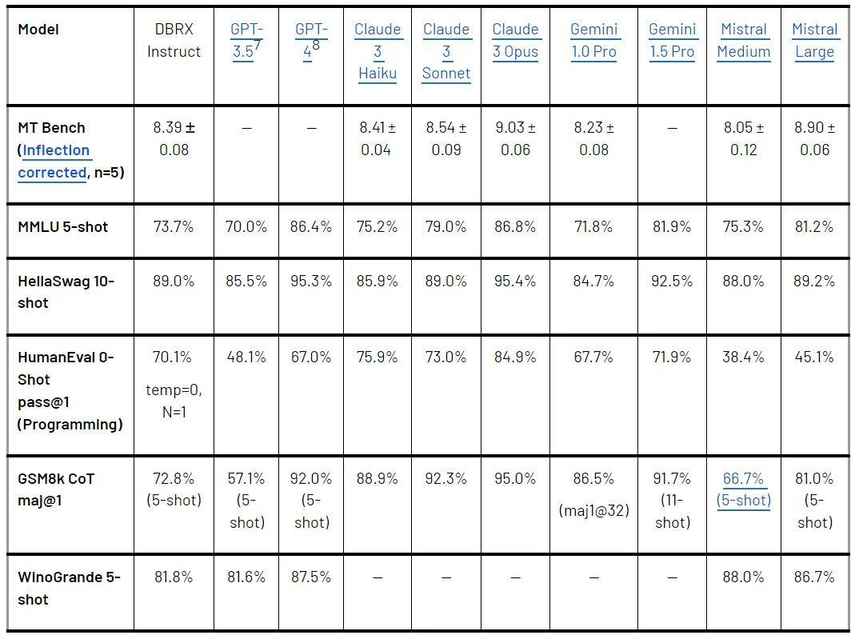

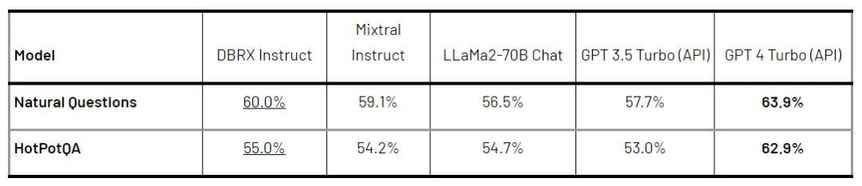

DBRX在语言理解、编程、数学等方面轻松击败了目前业内领先的开源大模型。在各项基准测试中,DBRX都表现优异,超越了GPT-3.5等模型。DBRX的效率很高,基于斯坦福MegaBlocks开源项目构建,处理速度极快。

DBRX是一种基于Transformer的仅解码器大语言模型,使用细粒度的专家混合架构,共有1320亿参数。与其他开源MoE模型相比,DBRX更细粒度,提供了更多可能的专家组合。DBRX还使用了一系列技术来提高模型质量。

通过一系列基准测试,DBRX为当前开源大模型领域树立了新标杆。它在综合基准、编程和数学基准以及MMLU方面表现优越。与闭源模型的比较也显示,DBRX具有相当的竞争力。

DBRX的训练效率也得到了研究人员的关注。训练混合专家模型可以显著提高训练的计算效率,这对于模型的发展至关重要。推理效率方面,DBRX也表现出色,使用MoE架构可以在模型质量和推理效率之间取得更好的平衡。

DBRX的训练过程耗时超过3个月,费用约1000万美元。若想在标准配置中运行DBRX,需要一台至少配备四个Nvidia H100 GPU的服务器或PC。Databricks的研发团队将持续完善DBRX并发布新版本,为生成式AI研究做出贡献。

DBRX的问世让开源大模型领域再次焕发活力,为研究和商业应用提供了更多可能性。随着技术的不断进步,我们可以期待DBRX在未来的发展中发挥更大的作用。